Le mondial marché des logiciels de web scraping a atteint 6,77 milliards de dollars en 2024 et devrait atteindre 109,8 milliards de dollars d'ici 2033, soit un TCAC remarquable de 35 %. Cette croissance explosive reflète l'importance croissante de l'intelligence économique basée sur les données, avec plus de 2,5 quintillions d'octets de données générés quotidiennement sur plus de 200 millions de sites Web actifs.

Pour les développeurs et les startups, le choix de la bonne solution de web scraping peut faire la différence entre un projet de collecte de données réussi et des heures interminables à lutter contre les CAPTCHA et les blocages IP.

Après avoir analysé les principaux fournisseurs desservant le marché des développeurs, nous avons identifié huit entreprises qui excellent dans différents domaines : rentabilité, capacités techniques, facilité d'intégration et valeur globale.

Forage AI est leader en matière de services d'IA gérés avec des solutions d'entreprise personnalisées, tandis que Sequentum domine le scraping visuel d'entreprise avec des plateformes low-code complètes. Scrapingdog offre un prix abordable inégalé avec le prix par demande le plus bas du secteur, et MRScraper révolutionne grâce à la simplicité alimentée par l'IA. Chaque fournisseur cible des cas d'utilisation spécifiques, qu'il s'agisse de startups soucieuses de leur budget ou d'opérations d'entreprise sophistiquées nécessitant une automatisation avancée.

1. Forage AI

Fournit des services de données gérés avec une expertise d'entreprise

Forage AI représente la gamme haut de gamme des services de web scraping gérés, offrant plus de 12 ans d'expertise spécialisée dans l'extraction de données automatisée à grande échelle à l'aide de modèles d'IA propriétaires. L'entreprise se concentre sur les entreprises clientes nécessitant des solutions personnalisées et une gestion complète des données plutôt que des API en libre-service.

Tranquillité d'esprit totale grâce à une tarification personnalisée qui donne aux clients une confiance totale dans leurs opérations de données. Forage AI gère et gère l'ensemble du pipeline de données du début à la fin afin que les clients puissent se concentrer sur la prise de décisions fondées sur les données. Contrairement à ses concurrents basés sur le bricolage, Forage AI fonctionne comme un service géré dans lequel les clients décrivent leurs besoins et reçoivent des solutions d'extraction entièrement personnalisées, y compris une maintenance continue et une assurance qualité.

Les fonctionnalités d'extraction alimentées par l'IA utilisent des modèles de langage avancés pour la compréhension des données contextuelles, en découpant le contenu non structuré avec précision. La plateforme gère le traitement de documents complexes, y compris les PDF, gère la surveillance des réseaux sociaux et fournit une structuration intelligente des données qui s'adapte aux modifications de contenu. Les robots d'exploration personnalisés gèrent des milliers de sites Web simultanément grâce au suivi des modifications intégré.

L'approche axée sur l'entreprise comprend des gestionnaires de comptes dédiés, un support d'intégration personnalisé et des processus d'assurance qualité complets. L'entreprise est spécialisée dans les cas d'utilisation complexes tels que l'extraction de données financières, la surveillance de la conformité réglementaire et l'agrégation de contenu à grande échelle. Les clients reçoivent des ensembles de données propres et validés plutôt que du contenu brut extrait.

La composante marché des données propose des ensembles de données prêts à l'emploi provenant de milliers de sites Web publics et de plateformes de réseaux sociaux, offrant un accès immédiat aux besoins de données courants. Les fonctionnalités NLP permettent d'interroger les données extraites en langage naturel, tandis que le processus d'assurance qualité éprouvé garantit fiabilité et précision.

Forage AI cible les entreprises ayant des exigences complexes en matière de données, des contraintes réglementaires ou des ressources techniques internes insuffisantes. Bien que les prix soient supérieurs aux alternatives en libre-service, l'approche gérée complète élimine les frais techniques et garantit des résultats cohérents et de haute qualité pour les applications critiques.

Les clients bénéficient de technologies d'IA avancées et d'une expertise approfondie en matière de web scraping, et de nombreux clients font confiance à Forage AI pour extraire de grandes quantités de données complexes et détaillées. Par exemple, certains suivent des industries entières avec une grande précision, en capturant chaque petit détail. La société a intégré des LLM et des agents d'IA en plus de son équipe de renommée mondiale pour fournir des informations personnalisées et concises aux clients.

2. Sequentum

Fournit un grattage visuel de niveau professionnel avec une puissance inégalée

Sequentum s'est imposée comme la plateforme de web scraping haut de gamme pour les entreprises, combinant plus de 15 ans d'expérience avec l'ensemble de fonctionnalités le plus complet disponible pour les opérations de données à grande échelle. En lançant récemment Sequentum Cloud parallèlement à sa plateforme d'entreprise phare, la société répond aux besoins des entreprises du Fortune 500, des agences gouvernementales et des institutions financières nécessitant l'extraction de données critiques.

Le modèle de service à trois niveaux couvre tous les besoins des entreprises avec Sequentum Cloud (PaaS) qui offre une plate-forme de données Web de niveau entreprise avec un générateur d'agents pointer-cliquer, une tarification à l'utilisation et une surveillance en temps réel. La plate-forme de données d'entreprise (sur site) permet le développement d'agents avancés, le déploiement sur site et l'intégration complète de l'automatisation. Managed Data Services (DaaS) fournit des services de données gérés haut de gamme avec la création de jeux de données personnalisés, des solutions clés en main, le développement d'agents experts et des équipes de support dédiées.

L'environnement de développement visuel distingue Sequentum grâce à son interface pointer-cliquer qui génère des agents de grattage sophistiqués sans codage. La capacité unique de la plateforme à compiler des agents exécutables autonomes offre une flexibilité inégalée : les utilisateurs peuvent créer des scrapers autonomes qui s'exécutent indépendamment sans dépendance de licence. Les utilisateurs avancés peuvent tirer parti de XPath, de regex et de la programmation personnalisée pour des scénarios complexes.

Les capacités techniques dominent le secteur grâce à une technologie exclusive de « transformateur » qui permet de basculer entre l'extraction à haute vitesse et le rendu complet du navigateur selon les besoins. La plateforme gère les sites Web les plus difficiles grâce à une randomisation avancée des empreintes digitales, à la résolution de CAPTCHA et à une adaptation automatique aux modifications du site. L'assurance qualité intégrée inclut la validation des données, la surveillance et les cadres de conformité.

Les fonctionnalités de l'infrastructure d'entreprise incluent une intégration complète des API, le contrôle de version pour les agents de scraping, des tableaux de bord de surveillance en temps réel et des pistes d'audit détaillées. La plateforme prend en charge les transformations complexes des données, l'enrichissement basé sur l'IA et la diffusion vers n'importe quel terminal. Les fonctionnalités de conformité garantissent le respect du RGPD et des réglementations du secteur.

Les commentaires des clients soulignent régulièrement la capacité de Sequentum à gérer des cas d'utilisation « impossibles » qui vont à l'encontre d'autres outils, même si la courbe d'apprentissage et la tarification peuvent constituer un défi pour les petites entreprises. Pour les entreprises qui recherchent une fiabilité à toute épreuve, des fonctionnalités complètes et un support dédié, Sequentum justifie son investissement premium par des capacités et des performances inégalées.

3. Grepsr

Permet une extraction à grande échelle gérée par des professionnels

Grepsr s'est imposé comme l'un des principaux fournisseurs de données en tant que service, combinant plus de dix ans d'expertise en matière de web scraping avec une gestion de projet de niveau entreprise. La société basée au Népal propose aux entreprises internationales des solutions d'extraction de données personnalisées, traitant des millions d'enregistrements par mois via des services gérés plutôt que des API en libre-service.

Une tarification transparente basée sur les enregistrements commence à 350$, les coûts étant déterminés en fonction de la complexité du projet, du volume de données et de la fréquence d'extraction. Contrairement à la facturation basée sur les demandes, Grepsr facture par enregistrement livré, garantissant ainsi aux clients de ne payer que pour les données utilisables. Les facteurs de tarification incluent la complexité du site Web, les mesures anti-bot, les exigences en matière de structure de données et les délais de livraison.

Une approche gérée globale affecte des chefs de projet et des équipes d'ingénierie dédiés à chaque engagement client. L'entreprise s'occupe de tout, de l'analyse initiale du site Web au développement de scrapers, en passant par la maintenance continue, l'assurance qualité et la fourniture de données. Les robots d'exploration personnalisés gèrent des authentifications complexes, des sites utilisant beaucoup de JavaScript et des systèmes anti-bots sophistiqués sans intervention du client.

L'infrastructure d'entreprise prend en charge une mise à l'échelle massive grâce à des processus d'assurance qualité automatisés, à de multiples formats de diffusion (API, FTP, stockage dans le cloud) et à des tableaux de bord de surveillance en temps réel. La plateforme gère des cas d'utilisation complexes, notamment l'extraction de documents PDF, la surveillance des réseaux sociaux et le traitement de contenu multilingue. Les fonctionnalités avancées incluent la validation des données, la détection des doublons et le formatage personnalisé.

Parmi les plus grandes marques des secteurs de l'automobile, de la finance, du commerce électronique et de la recherche figurent parmi leurs références éprouvées. Des études de cas démontrent l'extraction réussie de millions de documents PDF, la surveillance de la concurrence sur des milliers de sites Web et des solutions de données personnalisées pour les entreprises du Fortune 500. L'entreprise maintient un niveau élevé de fidélisation de la clientèle grâce à un support réactif et à une livraison fiable.

Les commentaires des clients mettent constamment en évidence une excellente gestion de projet, une expertise technique et une capacité à gérer des cas d'utilisation impossibles. Bien que les prix soient supérieurs aux alternatives en libre-service, l'approche entièrement gérée élimine la complexité technique et garantit une fiabilité de niveau professionnel aux organisations nécessitant une extraction de données cohérente et à grande échelle sans ressources de développement internes.

4. MrScraper

Révolutionne le scraping grâce à une simplicité basée sur l'IA

MrScraper est devenu le «ChatGPT pour le scraping», transformant l'extraction de données Web grâce à une IA en langage naturel qui élimine les obstacles techniques. La plateforme permet aux utilisateurs de simplement fournir une URL et de décrire les données dont ils ont besoin, l'IA gérant automatiquement le processus d'extraction complexe.

Des prix abordables commencent à 49$ par mois avec un système basé sur des jetons où les plans de base incluent des allocations de jetons importantes. Les utilisateurs peuvent accéder à des proxys résidentiels à partir de 2,50 $/Go avec rotation automatique et gestion des empreintes digitales. Le service «Done for You» ne coûte que 1$ par lien, fournissant une extraction entièrement gérée avec une configuration gérée par l'équipe de MrScraper.

L'extraction basée sur l'IA représente un changement de paradigme, passant des sélecteurs CSS traditionnels et XPath aux instructions en langage naturel. Les utilisateurs décrivent leurs besoins en matière de données en anglais clair, et l'IA identifie et extrait automatiquement les informations pertinentes. Cette approche rend le scraping sophistiqué accessible aux utilisateurs non techniques tout en conservant de puissantes options de personnalisation pour les développeurs.

Les fonctionnalités techniques incluent la rotation intelligente des proxys sur plus de 195 sites avec contournement automatique de l'anti-bot et du WAF. La plateforme gère les sites utilisant beaucoup de JavaScript, les CAPTCHA et les systèmes de protection sophistiqués sans configuration manuelle. La randomisation intégrée des empreintes digitales et l'intégration de proxy résidentiels garantissent des taux de réussite élevés, même sur des cibles difficiles.

L'expérience des développeurs met l'accent sur la simplicité avec une assistance par chat en direct 24h/24 et 7j/7, une documentation complète et une communauté Slack active. La plateforme propose à la fois une automatisation pilotée par l'IA et des options de personnalisation manuelle, permettant aux utilisateurs de choisir leur niveau de contrôle préféré. Les fonctionnalités d'intégration incluent la prise en charge des webhooks et l'accès à l'API pour les flux de travail automatisés.

Les témoignages de clients soulignent régulièrement la facilité d'utilisation et l'efficacité de la plateforme sur les sites qui bloquent généralement les scrapers. MrScraper s'adresse particulièrement aux équipes marketing, aux chercheurs et aux petites entreprises qui ont besoin d'une extraction de données fiable sans expertise technique. La combinaison de la simplicité de l'IA et d'une infrastructure de niveau professionnel la rend accessible aux utilisateurs quel que soit leur niveau de compétence.

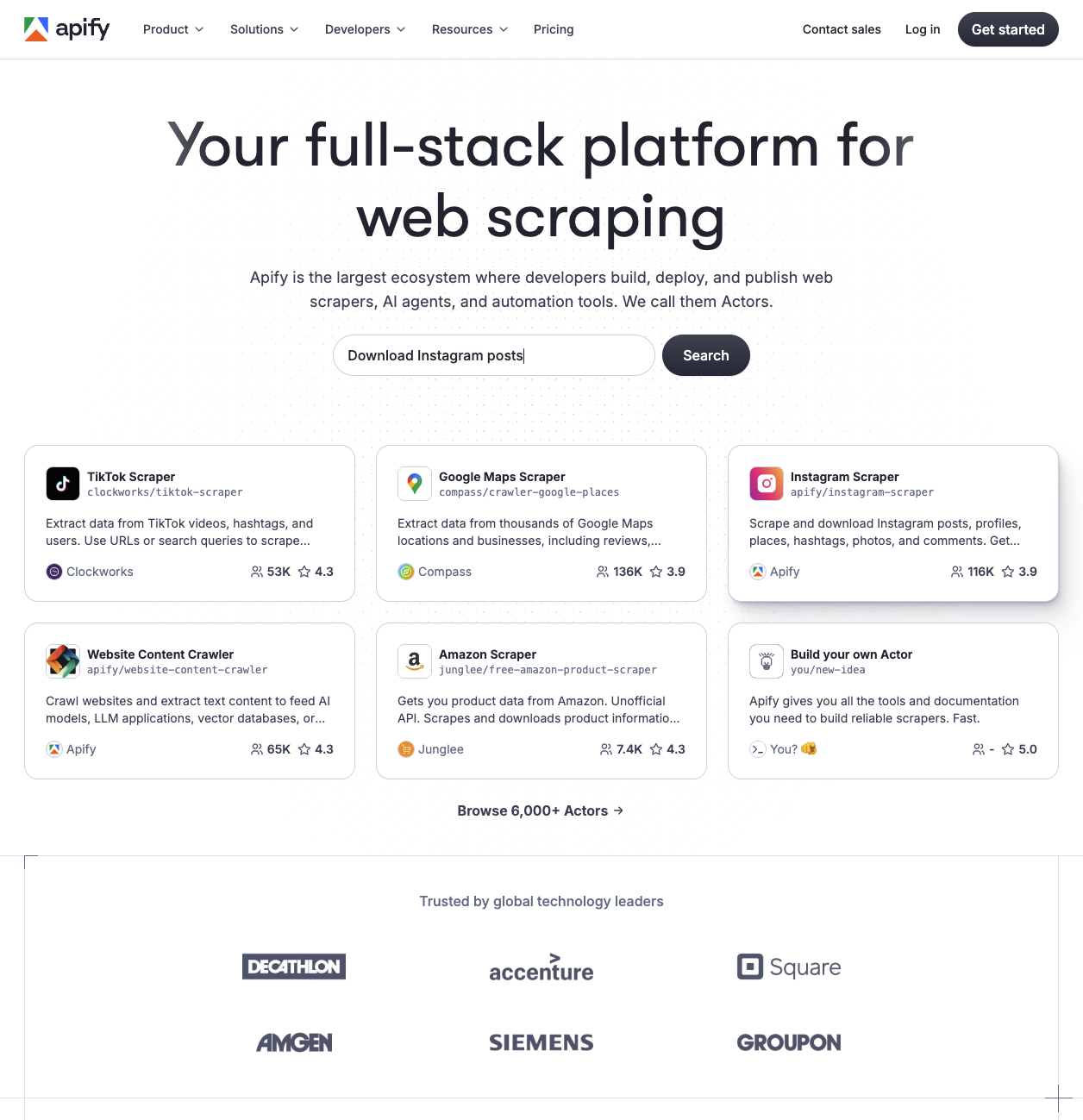

5. Apify

Transforme le web scraping grâce à une approche de plateforme complète

Apify a révolutionné le web scraping en créant une plateforme cloud complète qui combine des outils d'automatisation, une place de marché et une infrastructure en une seule solution. En tant que logiciel de web scraping #1 sur Capterra (2024), la société basée à Prague dessert plus de 55 002 utilisateurs actifs par mois grâce à son architecture innovante basée sur Actor.

La tarification basée sur la plateforme diffère de celle des services traditionnels, avec une facturation basée sur l'utilisation à partir de 39$ par mois pour 39$ de crédits de plateforme. Les unités de calcul (CU) coûtaient 0,40$ au départ, puis diminuaient à 0,25$ sur les forfaits professionnels. Le niveau gratuit fournit des crédits mensuels de 5$ pour l'évaluation. Les services proxy ajoutent 7 à 8 $/Go pour les adresses IP résidentielles et 0,60 à 1,00 $/IP pour les proxys de centre de données.

La place de marché Actor distingue Apify avec plus de 6 000 outils d'automatisation prédéfinis disponibles pour une utilisation immédiate. Les développeurs tirent 80 % des revenus de la publication d'Actors, créant ainsi un écosystème florissant de scrapers prêts à l'emploi pour les plateformes les plus populaires. Les modèles de tarification incluent des acteurs publics gratuits, des locations mensuelles (5 à 50$ et plus en général) et des options de paiement au résultat.

L'infrastructure technique met l'accent sur l'évolutivité sans serveur grâce à la conteneurisation basée sur Docker et au provisionnement automatique des ressources. La plateforme prend en charge les SDK JavaScript et Python avec des fonctionnalités complètes d'automatisation des navigateurs via Puppeteer, Playwright et Selenium. Le stockage des données comprend des ensembles de données structurés, des magasins de valeurs clés et des files de requêtes avec des options d'exportation JSON/CSV/Excel.

Les outils de développement excellent grâce à une documentation complète, à des cours Apify Academy et à un support communautaire actif. La plateforme traite plus de 40 millions d'exécutions d'Actor par mois et 6,8 milliards d'appels d'API par an, tout en maintenant une disponibilité de 99,95 %. Les API RESTful prennent en charge 250 000 requêtes par minute grâce à des notifications Webhook et à des intégrations tierces.

Les commentaires des clients soulignent la facilité d'utilisation, la rentabilité et la valeur des solutions prédéfinies. Les utilisateurs signalent des économies de 10 à 20 fois supérieures à celles réalisées avec des alternatives telles que Clearbit, mais remarquent la complexité pour les non-développeurs. La plateforme dessert efficacement de multiples segments d'utilisateurs : les développeurs apprécient la flexibilité, les petites entreprises apprécient les solutions prêtes à l'emploi et les entreprises bénéficient de fonctionnalités de fiabilité et de conformité.

6. ScraperAPI

Excelle dans le scraping Web convivial pour les développeurs

ScraperAPI s'est imposé comme la référence pour les développeurs en quête de fiabilité sans complexité. Traitant plus de 5 milliards de demandes par mois dans plus de 10 000 entreprises, le service simplifie le web scraping en gérant automatiquement les proxys, les navigateurs et les CAPTCHA via un point de terminaison d'API unique.

Le modèle de tarification basé sur les crédits de la société commence à 49 dollars par mois pour 100 000 crédits d'API, ce qui le rend nettement plus accessible que les alternatives d'entreprise à partir de 500$. Les requêtes de base ne consomment qu'un seul crédit, tandis que les opérations complexes telles que le rendu JavaScript avec des proxys premium peuvent atteindre 25 crédits. Cette approche de paiement au succès ne facture que les codes de statut 2xx, éliminant ainsi le gaspillage lié aux demandes échouées.

Les capacités techniques sont centrées sur un pool de plus de 40 millions de proxys répartis dans plus de 50 pays, avec trois niveaux premium offrant des taux de réussite et des vitesses différents. Le service maintient un taux de réussite global de 62,9 %, supérieur à la moyenne du secteur de 59,3 %, tout en atteignant 98 % de succès sur les sites de commerce électronique et 93 % sur les moteurs de recherche. Les fonctionnalités de rendu JavaScript gèrent le contenu dynamique via des navigateurs Chrome sans en-tête, ce qui est essentiel pour les applications modernes à page unique.

L'expérience des développeurs est bien notée grâce à des kits de développement complets pour Python, Node.js, PHP, Ruby et Java. La documentation comprend de nombreux exemples de code et les utilisateurs signalent des temps de configuration inférieurs à cinq minutes. Cependant, les temps de réponse sont en moyenne de 11,4 secondes, soit légèrement en dessous de la norme industrielle de 9,4 secondes, ce qui peut avoir un impact sur les applications critiques en termes de performances.

Les commentaires des clients soulignent constamment la facilité d'utilisation et la fiabilité du support client, bien que certains utilisateurs remarquent la complexité du système de crédit et les limites géographiques des plans de niveau inférieur. Pour les startups et les entreprises de taille moyenne nécessitant des coûts prévisibles et une intégration simple, ScraperAPI offre une valeur ajoutée importante.

7. Octoparse

Dirige le grattage visuel avec une simplicité sans code

Octoparse domine le marché du visual web scraping avec l'interface la plus conviviale et les meilleures capacités de détection automatique alimentées par l'IA, desservant plus d'un million d'utilisateurs dans le monde grâce à son approche sans code de l'extraction de données. La plateforme propose plus de 469 modèles prédéfinis pour les sites Web les plus populaires et une infrastructure complète basée sur le cloud.

La tarification échelonnée permet à tous les utilisateurs de bénéficier d'un plan entièrement gratuit pour les petits projets (10 tâches, exécution locale uniquement), d'un plan standard à 119 dollars par mois (100 tâches, 6 processus cloud simultanés) et d'un plan professionnel à 299 dollars par mois (250 tâches, 20 processus simultanés). Les forfaits Enterprise proposent une tarification personnalisée avec plus de 750 tâches, plus de 40 processus simultanés et une gestion de la réussite dédiée.

La détection automatique par IA de la plateforme identifie automatiquement les modèles de données sans configuration manuelle, tandis que le concepteur de flux de travail visuel permet de créer une interface par glisser-déposer. Octoparse gère les sites Web dynamiques, notamment JavaScript, AJAX et le défilement infini grâce à la rotation IP intégrée, à la résolution CAPTCHA et à la gestion des proxys. L'extraction dans le cloud 24h/24 et 7j/7 avec planification garantit une collecte de données continue.

L'expérience utilisateur reçoit d'excellentes notes avec 4,7/5 étoiles sur Capterra sur plus de 105 avis et 4,8/5 sur G2, les utilisateurs louant constamment la facilité d'utilisation et les fonctionnalités puissantes. La plateforme cible les utilisateurs non techniques, les analystes commerciaux, les sociétés de commerce électronique et les organismes de recherche grâce à des didacticiels vidéo complets et à un support client 24h/24 et 7j/7 pour les forfaits payants.

Contrairement aux solutions basées sur le code nécessitant une expertise technique, Octoparse fournit un scraping complet de bout en bout sans connaissances en programmation. La vaste bibliothèque de modèles couvre les scénarios de scraping les plus courants, tandis que les fonctionnalités basées sur l'IA gèrent automatiquement les modifications de la structure du site Web. L'infrastructure basée sur le cloud garantit une disponibilité et une évolutivité élevées pour les projets d'extraction de données au niveau de l'entreprise, ce qui en fait la solution idéale pour les entreprises à la recherche de solutions de scraping clés en main.

8. Scrapingdog

Excelle en matière d'API dédiées rentables

Scrapingdog s'est positionnée comme la solution de web scraping la plus rentable du marché, atteignant le prix le plus bas pour 1 000 appels (0,063$ à l'échelle) tout en maintenant un taux de réussite de 100 % sur les principales plateformes. Fondée en 2018, la société traite plus de 400 millions de demandes par mois en mettant l'accent sur les API dédiées pour des plateformes spécifiques.

Le leadership en matière de tarification favorise l'adoption avec des forfaits à partir de 40$ par mois, offrant un rapport qualité-prix exceptionnel par rapport à la concurrence. Le système basé sur les crédits fournit 1 000 crédits gratuits pour les tests, avec des coûts par demande commençant à 0,0002$ et tombant à 0,000063$ pour les volumes plus élevés. Les différentes API consomment des crédits différents : Google Search coûte 5 crédits par demande, tandis que le web scraping en général n'utilise qu'un seul crédit.

Une approche d'API dédiée différencie Scrapingdog des services de scraping généraux en proposant des points de terminaison spécialisés pour Amazon, Google, LinkedIn, Instagram, Indeed et d'autres plateformes majeures. Ces API dédiées renvoient des données JSON analysées plutôt que du code HTML brut, ce qui élimine le travail de post-traitement. Le Web Scraper général gère tous les sites Web dotés de fonctionnalités de rotation de proxy et de rendu JavaScript haut de gamme.

Les indicateurs de performance impressionnent régulièrement avec des temps de réponse moyens de 2,5 secondes (nettement plus rapides que la moyenne du secteur de 9,4 secondes) et des taux de réussite de 100 % sur les plateformes testées, notamment Amazon, Glassdoor et Idealista. La prise en charge de la simultanéité élevée sur les forfaits premium permet un traitement parallèle sans dégradation des performances.

L'expérience des développeurs met l'accent sur la simplicité avec une documentation claire, un support client 24h/24 et 7j/7 et des exemples d'intégration dans plusieurs langages de programmation. Les utilisateurs peuvent tester les API directement depuis le tableau de bord sans écrire de code, tandis que le système de messagerie fournit une assistance technique immédiate. Pour les développeurs qui ont besoin d'un scraping fiable et abordable avec un support de plateforme spécialisé, Scrapingdog offre une valeur exceptionnelle.

9. Scrapfly

Combine l'expérience des développeurs avec des taux de réussite supérieurs

Scrapfly s'est positionnée comme l'alternative aux solutions d'entreprise axée sur les développeurs, atteignant un taux de réussite de 99,1 %, soit nettement supérieur à la moyenne de 59,3 % du secteur, tout en maintenant des prix accessibles et une excellente documentation. Fondée pour combler le manque de complexité des services de web scraping, la plateforme traite plus de 5 milliards de demandes par mois auprès de plus de 30 000 utilisateurs.

La tarification basée sur les crédits commence à 30$ par mois pour 200 000 crédits d'API, avec une consommation variable en fonction des fonctionnalités utilisées. Le scraping de base consomme 1 crédit par demande, tandis que les fonctionnalités avancées telles que le rendu JavaScript et les proxys résidentiels (plus de 130 millions d'adresses IP provenant de plus de 120 pays) augmentent les coûts proportionnellement. Le système fournit une facturation prévisible par rapport aux alternatives basées sur la bande passante.

Les fonctionnalités techniques mettent l'accent sur le contournement des robots grâce à leur système propriétaire ASP (Anti-Scraping Protection), qui met à niveau dynamiquement les demandes pour surmonter les blocages. Le rendu JavaScript utilise des navigateurs cloud dotés d'un support d'exécution personnalisé, tandis que la fonction de conversion de format génère du HTML, du JSON, du Markdown ou du Clean HTML de manière native. La gestion des sessions assure la cohérence entre les séquences de demandes.

L'expérience des développeurs de la plateforme reçoit régulièrement des notes élevées en termes de conception d'API, de qualité de la documentation et de facilité d'intégration. Les utilisateurs signalent des temps de configuration inférieurs à quelques heures à l'aide d'exemples de code complets provenant de référentiels GitHub contenant plus de 40 scrapers cibles. Les SDK prennent en charge Python avec des fonctionnalités asynchrones, TypeScript/JavaScript pour Node.js et des intégrations de framework, notamment LangChain, LLamaIndex et Scrapy middleware.

Les innovations récentes incluent l'extraction de données alimentée par l'IA à l'aide des invites LLM et l'extraction automatique des produits, des critiques et des articles. L'approche de plate-forme unifiée réduit la complexité par rapport à la gestion de services de proxy, de navigateur et d'extraction distincts. Les commentaires des clients mettent en avant la fiabilité et la rentabilité, bien que les utilisateurs remarquent des coûts imprévus potentiels lorsque les fonctionnalités ASP se déclenchent automatiquement.

10. Firecrawl

Transforme le grattage grâce à une extraction basée sur l'IA

Firecrawl révolutionne le web scraping grâce à une extraction de données native à l'IA qui permet de comprendre le contenu de manière sémantique plutôt que structurelle. Cette plate-forme soutenue par Y Combinator élimine la fragilité des sélecteurs CSS traditionnels, ce qui en fait le choix préféré des développeurs qui créent des applications d'IA et des pipelines de données modernes.

Une tarification adaptée aux start-up commence par un niveau gratuit offrant 500 crédits, suivi par des plans Hobby à 16$ par mois pour 3 000 crédits. Le niveau Standard coûte 83$ par mois pour 100 000 crédits, tandis que Growth atteint 333$ par mois pour 500 000 crédits. Les clients d'entreprise reçoivent des crédits illimités avec des limites de taux et des SLA personnalisés. Ce système de crédit simple facture un crédit par page extraite.

L'agent FIRE-1 de la plateforme utilise une IA propriétaire pour comprendre le contenu de manière sémantique, ce qui permet aux utilisateurs de décrire les besoins d'extraction en anglais clair plutôt que d'écrire des sélecteurs fragiles. Firecrawl convertit les sites Web en markdown épuré, en JSON et en données structurées spécialement optimisées pour les applications LLM. Le service gère l'exécution avancée de JavaScript, la prise en charge du SPA et l'attente intelligente via plusieurs points de terminaison d'API.

L'expérience des développeurs est bien notée grâce à une documentation complète, à des SDK pour Python et Node.js, ainsi qu'à des intégrations intégrées pour LangChain, LLamaIndex et Zapier. La plateforme affiche des performances 50 fois plus rapides que ses concurrents dans les benchmarks, tout en permettant des économies de 2/3 de jetons par rapport à GPT-4 lors de l'utilisation de données extraites. Étant open source sous AGPL-3.0, les développeurs peuvent s'auto-héberger pour un contrôle maximal.

Les témoignages de clients soulignent régulièrement les améliorations en termes de fiabilité et de rapidité par rapport aux approches de grattage traditionnelles. Contrairement aux solutions basées sur un proxy nécessitant une maintenance constante, l'approche basée sur l'IA de Firecrawl s'adapte automatiquement aux changements de mise en page tout en gérant les mesures anti-bot de manière transparente. Pour les développeurs qui créent des chatbots, des systèmes RAG et des bases de connaissances, Firecrawl offre une qualité de données et une rapidité de développement supérieures.

Choisir la solution de web scraping adaptée à vos besoins

Pour les besoins des entreprises gérées, les solutions d'IA personnalisées de Forage AI et la plateforme visuelle complète de Sequentum offrent une fiabilité à toute épreuve. Startups soucieuses de leur budget profitez de la tarification de 0,063/1 000 requêtes de Scrapingdog et des API de plateforme dédiées. Applications axées sur l'IA devrait envisager l'extraction du langage naturel de MrScraper ou les capacités de compréhension sémantique de Firecrawl.

Exigences basées sur les projets répondent aux services gérés de Grepsr, à partir de 350$ avec une gestion de projet dédiée. Besoins de grattage visuel - pointez vers la plateforme no-code d'Octoparse avec plus de 469 modèles et une détection automatique par IA, tandis que développeurs préférant les solutions prédéfinies trouvera la place de marché de plus de 6 000 acteurs d'Apify d'une valeur inestimable.

Startups en croissance devrait examiner les plans conviviaux pour les développeurs de 49$ par mois de ScraperAPI, tandis que les équipes qui ont besoin d'une flexibilité maximale profitez des taux de réussite supérieurs de 95,9 % et des fonctionnalités d'API complètes de Scrapfly.

Conclusion

Le paysage du web scraping propose diverses solutions pour tous les budgets et toutes les exigences techniques, de l'extraction du langage naturel basée sur l'IA aux plateformes d'entreprise complètes. Le succès dépend de l'adéquation des capacités du fournisseur à des cas d'utilisation spécifiques : contraintes budgétaires, exigences techniques, besoins d'intégration de l'IA et capacités de l'équipe de développement.

Scrapingdog offre un rapport qualité-prix exceptionnel pour des opérations soucieuses des coûts, tandis que MrScraper est à la pointe de la simplicité native de l'IA pour les utilisateurs non techniques. Sequentum transforme les opérations de l'entreprise grâce à un développement visuel complet, et Forage AI fournit un service haut de gamme pour les exigences gérées complexes.

L'évolution rapide vers l'extraction basée sur l'IA et la demande croissante de données structurées font du choix du bon partenaire un élément crucial pour un succès à long terme. Envisagez de commencer par des essais gratuits auprès de plusieurs fournisseurs pour évaluer les performances par rapport à vos objectifs spécifiques avant de vous engager dans des plans annuels. L'investissement dans une infrastructure de web scraping de qualité est généralement rentable grâce à la réduction du temps de développement, à l'amélioration de la qualité des données et à l'amélioration de l'intelligence économique qui permet de prendre de meilleures décisions.

Je suis le co-fondateur et PDG de Massive. En plus de travailler sur des startups, je suis musicienne, athlète, mentor, animatrice d'événements et bénévole.

Customer reviews

Question fréquemment posée

Quel est le service de web scraping le moins cher pour les startups ?

+

Scrapingdog propose les tarifs les plus abordables à 0,063$ pour 1 000 demandes à grande échelle, avec des forfaits à partir de 40$ par mois. MrScraper propose également des options économiques à partir de 49$ par mois avec une extraction alimentée par l'IA, tandis que Firecrawl propose un niveau gratuit avec 500 crédits pour les tests.

Quel outil de web scraping convient le mieux aux débutants?

+

MrScraper est idéal pour les débutants grâce à son interface en langage naturel alimentée par l'IA : il vous suffit de fournir une URL et de décrire les données dont vous avez besoin. Octoparse excelle également pour les utilisateurs non techniques avec son interface visuelle pointer-cliquer et plus de 469 modèles prédéfinis pour les sites Web populaires.

Ai-je besoin de compétences en codage pour utiliser les services de web scraping ?

+

Aucun codage n'est requis pour plusieurs plateformes. MrScraper utilise l'IA et des commandes en langage naturel, Octoparse fournit une interface visuelle par glisser-déposer et Sequentum propose un grattage par pointer-cliquer. Cependant, des services tels que ScraperAPI et Scrapingdog nécessitent des connaissances de base en matière d'intégration d'API.

Quelle est la différence entre les API de web scraping et les services gérés ?

+

Les API de grattage Web (comme ScraperAPI, Scrapingdog) vous obligent à intégrer et à gérer vous-même le processus de scraping, ce qui vous permet de mieux contrôler et de réduire les coûts. Les services gérés (tels que Grepsr, Forage AI) s'occupent de tout pour vous, y compris la configuration, la maintenance et la fourniture des données, mais à des coûts plus élevés, à partir de 350 à 500 dollars par mois.

Quel service de web scraping gère le mieux les CAPTCHA et la détection des bots ?

+

Sequentum est à la pointe des capacités anti-bots grâce à la technologie avancée de randomisation des empreintes digitales et de «transformateur». MrScraper et ScraperAPI excellent également dans le contournement automatique des CAPTCHA, tandis que Scrapfly offre un taux de réussite de 95,9 % grâce à son système propriétaire de protection anti-grattage (ASP).

Les services de web scraping peuvent-ils extraire des données de sites web utilisant beaucoup de JavaScript ?

+

Oui, la plupart des services modernes gèrent le rendu JavaScript. Firecrawl est spécialisé dans les applications à page unique, ScraperAPI propose des navigateurs Chrome sans en-tête, Sequentum fournit une automatisation complète des navigateurs et Apify prend en charge Puppeteer, Playwright et Selenium pour les sites JavaScript complexes.

L'utilisation des services de web scraping est-elle légale ?

+

Le web scraping est généralement légal lorsque vous collectez des données accessibles au public et que vous respectez les conditions d'utilisation d'un site Web. Des services tels que Forage AI et Grepsr mettent l'accent sur la conformité aux réglementations GDPR et CCPA. Consultez toujours les fichiers robots.txt et les conditions d'utilisation du site Web cible avant de procéder au scraping.

Quel service convient le mieux au grattage des grandes entreprises ?

+

Sequentum Enterprise est à la pointe des opérations à grande échelle avec des fonctionnalités complètes à partir de 5 000$ par an. Forage AI fournit des services gérés complets pour les besoins complexes des entreprises, tandis que Grepsr propose une extraction gérée évolutive à partir de 350 dollars pour les moyennes entreprises.

Comment choisir entre les différents modèles de tarification?

+

La tarification basée sur le crédit (ScraperAPI, MrScraper, Firecrawl) fonctionne bien pour des modèles d'utilisation prévisibles. La tarification au paiement par enregistrement (Grepsr) garantit que vous ne payez que pour les données utilisables. Les services gérés (Forage AI) éliminent les frais techniques mais coûtent plus cher. Tenez compte de votre expertise technique, de votre volume de données et de vos contraintes budgétaires.

Quel est le meilleur service de web scraping pour les projets d'IA et d'apprentissage automatique ?

+

Firecrawl excelle dans les projets d'IA avec des résultats optimisés pour le LLM et une compréhension sémantique. ForageAI fournit une extraction basée sur l'IA avec une compréhension des données contextuelles. MrScraper propose une extraction du langage naturel pilotée par l'IA, tandis que la place de marché d'Apify comprend de nombreux outils d'automatisation axés sur l'IA.