Глобальное рынок программного обеспечения для парсинга веб-страниц достиг 6,77 миллиарда долларов в 2024 году и, по прогнозам, вырастет до 109,8 миллиарда долларов к 2033 году, при этом среднегодовой темп роста составит 35%. Этот стремительный рост отражает растущее значение бизнес-аналитики на основе данных: ежедневно на более чем 200 миллионах активных веб-сайтов генерируется более 2,5 квинтиллионов байт данных.

Для разработчиков и стартапов выбор подходящего решения для очистки веб-страниц может стать ключом к успеху проекта по сбору данных и бесконечной многочасовой борьбе с CAPTCHA и блокировками IP-адресов.

Проанализировав ведущих поставщиков, обслуживающих рынок разработчиков, мы выделили восемь компаний, которые преуспевают в различных областях: экономическая эффективность, технические возможности, простота интеграции и общая стоимость.

Forage AI лидирует в сфере управляемых услуг искусственного интеллекта с индивидуальными корпоративными решениями, в то время как Sequentum доминирует в корпоративной визуальной очистке с комплексными платформами с низким кодом. Scrapingdog предлагает непревзойденную доступность с самой низкой в отрасли ценой за каждый запрос и MrScraper революционизирует благодаря простоте на основе искусственного интеллекта. Каждый поставщик ориентирован на конкретные сценарии использования: от стартапов с ограниченным бюджетом до сложных корпоративных операций, требующих расширенной автоматизации.

1. Искусственный интеллект в области кормов

Предоставляет услуги управляемых данных, опираясь на опыт предприятия

Искусственный интеллект для кормов представляет собой премиальный сегмент услуг по управляемой очистке веб-страниц, предлагающий более 12 лет специализированного опыта в крупномасштабном автоматизированном извлечении данных с использованием собственных моделей искусственного интеллекта. Компания ориентирована на корпоративных клиентов, которым нужны индивидуальные решения и комплексное управление данными, а не API самообслуживания.

Абсолютное спокойствие благодаря индивидуальным ценам, которые дают клиентам полную уверенность в своих операциях с данными. Искусственный интеллект Forage управляет всем конвейером данных и обслуживает его от начала до конца, чтобы клиенты могли сосредоточиться на принятии решений на основе данных. В отличие от конкурентов, использующих технологию «сделай сам», Forage AI представляет собой управляемый сервис, где клиенты описывают свои потребности и получают полностью персонализированные решения по добыче полезных ископаемых, включая текущее техническое обслуживание и контроль качества.

Возможности извлечения на основе искусственного интеллекта используют передовые языковые модели для понимания контекстных данных и точного анализа неструктурированного контента. Платформа обрабатывает сложные документы, в том числе PDF-файлы, осуществляет мониторинг социальных сетей и обеспечивает интеллектуальное структурирование данных, адаптирующееся к изменениям контента. Специализированные сканеры обрабатывают тысячи веб-сайтов одновременно с помощью встроенного отслеживания изменений.

Подход, ориентированный на предприятие, включает специальных менеджеров по работе с клиентами, индивидуальную интеграционную поддержку и комплексные процессы обеспечения качества. Компания специализируется на сложных сценариях использования, таких как извлечение финансовых данных, мониторинг соответствия нормативным требованиям и крупномасштабное агрегирование контента. Клиенты получают чистые, проверенные наборы данных, а не необработанный контент.

Компонент Data Marketplace предлагает готовые к использованию наборы данных с тысяч общедоступных веб-сайтов и социальных сетей, обеспечивая немедленный доступ к общим потребностям в данных. Возможности NLP позволяют запрашивать извлеченные данные на естественном языке, а проверенный временем процесс контроля качества обеспечивает надежность и точность.

Искусственный интеллект для кормов предназначен для предприятий со сложными требованиями к данным, нормативными ограничениями или недостаточными внутренними техническими ресурсами. Хотя цены и превосходят альтернативные варианты самообслуживания, комплексный управляемый подход устраняет технические издержки и обеспечивает стабильные и высококачественные результаты для критически важных приложений.

Клиенты извлекают выгоду из передовых технологий искусственного интеллекта и глубокого опыта обработки веб-страниц, при этом многие клиенты полагаются на искусственный интеллект Forage для извлечения больших объемов сложных и подробных данных. Например, некоторые с высокой точностью отслеживают целые отрасли, фиксируя каждую мельчайшую деталь. Компания объединила LLM и агентов по искусственному интеллекту в свою команду мирового уровня, чтобы предоставлять клиентам персонализированную и краткую информацию.

2. Секвентум

Обеспечивает визуальную очистку данных корпоративного уровня с непревзойденной мощностью

секвентум зарекомендовала себя как корпоративная платформа для очистки веб-страниц премиум-класса, сочетающая более 15 лет опыта с наиболее полным набором функций, доступных для крупномасштабных операций с данными. Недавно запустив Sequentum Cloud вместе со своей флагманской корпоративной платформой, компания обслуживает компании из списка Fortune 500, государственные учреждения и финансовые учреждения, которым требуется извлечение критически важных данных.

Трехуровневая модель обслуживания отвечает всем корпоративным требованиям, а Sequentum Cloud (PaaS) предлагает платформу веб-данных корпоративного уровня с конструктором агентов «укажи и щелкни», оплатой по факту использования и мониторингом в реальном времени. Платформа корпоративных данных (локальная) обеспечивает расширенную разработку агентов, локальное развертывание и полную интеграцию автоматизации. Managed Data Services (DaaS) — это универсальные сервисы управления данными, включающие создание индивидуальных наборов данных, готовые решения, разработку экспертных агентов и специализированные группы поддержки.

Визуальная среда разработки отличает Sequentum своим интерфейсом «укажи и щелкни», который генерирует сложные агенты очистки без программирования. Уникальная способность платформы компилировать автономные исполняемые агенты обеспечивает непревзойденную гибкость — пользователи могут создавать автономные парсеры, работающие независимо друг от друга без лицензионных зависимостей. Опытные пользователи могут использовать XPath, regex и настраиваемое программирование для сложных сценариев.

Технические возможности лидируют в отрасли благодаря запатентованной технологии «трансформер», которая при необходимости переключается между высокоскоростным извлечением и полным рендерингом в браузере. Платформа справляется с самыми сложными веб-сайтами с помощью усовершенствованной рандомизации отпечатков пальцев, распознавания CAPTCHA и автоматической адаптации к изменениям на сайте. Встроенная система контроля качества включает проверку данных, мониторинг и соответствие нормативным требованиям.

Функции корпоративной инфраструктуры включают комплексную интеграцию API, контроль версий для агентов очистки, панели мониторинга в реальном времени и подробные журналы аудита. Платформа поддерживает комплексное преобразование данных, обогащение данных с помощью искусственного интеллекта и доставку на любую конечную точку. Функции соответствия требованиям обеспечивают соблюдение GDPR и отраслевых нормативных актов.

Отзывы клиентов постоянно подчеркивают способность Sequentum справляться с «невозможными» сценариями использования, превосходящими другие инструменты, хотя небольшие организации могут столкнуться с трудностями, связанными с обучением и ценами. Для предприятий, которым требуется непревзойденная надежность, комплексные функции и специализированная поддержка, Sequentum оправдывает свои премиальные инвестиции непревзойденными возможностями и производительностью.

3. Грепер

Обеспечивает профессионально управляемую экстракцию в нужном масштабе

Грепер зарекомендовала себя как ведущий поставщик данных как услуга, сочетая более десяти лет опыта работы с веб-сайтингом с управлением проектами корпоративного уровня. Базирующаяся в Непале компания предоставляет глобальным предприятиям специализированные решения по извлечению данных, ежемесячно обрабатывая миллионы записей с помощью управляемых сервисов, а не API самообслуживания.

Прозрачное ценообразование на основе записей начинается с 350 долларов США и определяется сложностью проекта, объемом данных и частотой извлечения данных. В отличие от выставления счетов на основе запросов, Grepsr взимает плату за каждую доставленную запись, гарантируя, что клиенты платят только за полезные данные. Ценовые факторы включают сложность веб-сайта, меры по борьбе с ботами, требования к структуре данных и сроки доставки.

Комплексный управляемый подход предусматривает назначение специальных руководителей проектов и инженерных групп для каждого взаимодействия с клиентом. Компания занимается всем: от первоначального анализа веб-сайта и разработки парсера до текущего обслуживания, контроля качества и доставки данных. Специализированные сканеры обрабатывают сложную аутентификацию, сайты с большим количеством JavaScript и сложные системы защиты от ботов без вмешательства клиента.

Корпоративная инфраструктура поддерживает масштабное масштабирование благодаря автоматизированным процессам обеспечения качества, нескольким форматам доставки (API, FTP, облачное хранилище) и панелям мониторинга в реальном времени. Платформа подходит для сложных сценариев использования, включая извлечение PDF-документов, мониторинг социальных сетей и обработку многоязычного контента. Расширенные функции включают проверку данных, обнаружение дубликатов и настраиваемое форматирование.

Доказанный послужной список включает крупные бренды в автомобильном, финансовом, электронном и исследовательском секторах. Тематические исследования свидетельствуют об успешном извлечении данных из миллионов PDF-документов, мониторинге конкурентов на тысячах веб-сайтов и специализированных информационных решениях для компаний из списка Fortune 500. Благодаря оперативной поддержке и надежной доставке компания обеспечивает высокий уровень удержания клиентов.

Отзывы клиентов неизменно подчеркивают превосходное управление проектами, технический опыт и способность справляться с невозможными сценариями использования. Несмотря на то, что цены превосходят цены на альтернативные варианты самообслуживания, полностью управляемый подход устраняет технические сложности и обеспечивает надежность корпоративного уровня для организаций, которым требуется крупномасштабное и последовательное извлечение данных без внутренних ресурсов для разработки.

4. Мистер Скрепер

Революционизирует очистку благодаря простоте на базе искусственного интеллекта

Мистер Скрепер появился как «ChatGPT для очистки», который позволяет извлекать веб-данные с помощью искусственного интеллекта на естественном языке, устраняя технические барьеры. Платформа позволяет пользователям просто указать URL-адрес и описать, какие данные им нужны, а искусственный интеллект автоматически обрабатывает сложный процесс извлечения.

Доступные цены начинаются с 49 долларов в месяц при использовании системы на основе токенов, где базовые планы включают значительное распределение токенов. Пользователи могут получить доступ к резидентным прокси-серверам по цене от 2,50 долл. США за ГБ с автоматической ротацией и управлением отпечатками пальцев. Услуга «Готово для вас» стоит всего 1 доллар за ссылку и обеспечивает полностью управляемое извлечение данных с настройкой, выполняемой командой MrScraper.

Экстракция на основе искусственного интеллекта представляет собой смену парадигмы от традиционных селекторов CSS и XPath к инструкциям на естественном языке. Пользователи описывают свои потребности в данных простым английским языком, а искусственный интеллект автоматически определяет и извлекает соответствующую информацию. Такой подход делает сложную очистку доступной для нетехнических пользователей, сохраняя при этом широкие возможности настройки для разработчиков.

Технические возможности включают интеллектуальную ротацию прокси в более чем 195 локациях с автоматическим обходом защиты от ботов и обхода WAF. Платформа обрабатывает сайты с большим количеством JavaScript, капчи и сложные системы защиты без ручной настройки. Встроенная функция рандомизации отпечатков пальцев и интеграция с резидентными прокси-серверами обеспечивают высокие показатели успеха даже при решении сложных задач.

Опыт разработчиков подчеркивает простоту благодаря круглосуточной поддержке в чате, исчерпывающей документации и активному сообществу Slack. Платформа предлагает как автоматизацию на основе искусственного интеллекта, так и ручную настройку, что позволяет пользователям выбирать предпочтительный уровень управления. Возможности интеграции включают поддержку веб-хуков и доступ к API для автоматизированных рабочих процессов.

Отзывы клиентов постоянно подчеркивают простоту использования и эффективность платформы на сайтах, которые обычно блокируют скреперы. MrScraper особенно подходит маркетинговым командам, исследователям и малым предприятиям, которым требуется надежное извлечение данных без технических знаний. Сочетание простоты искусственного интеллекта и инфраструктуры профессионального уровня делает его доступным для пользователей любого уровня квалификации.

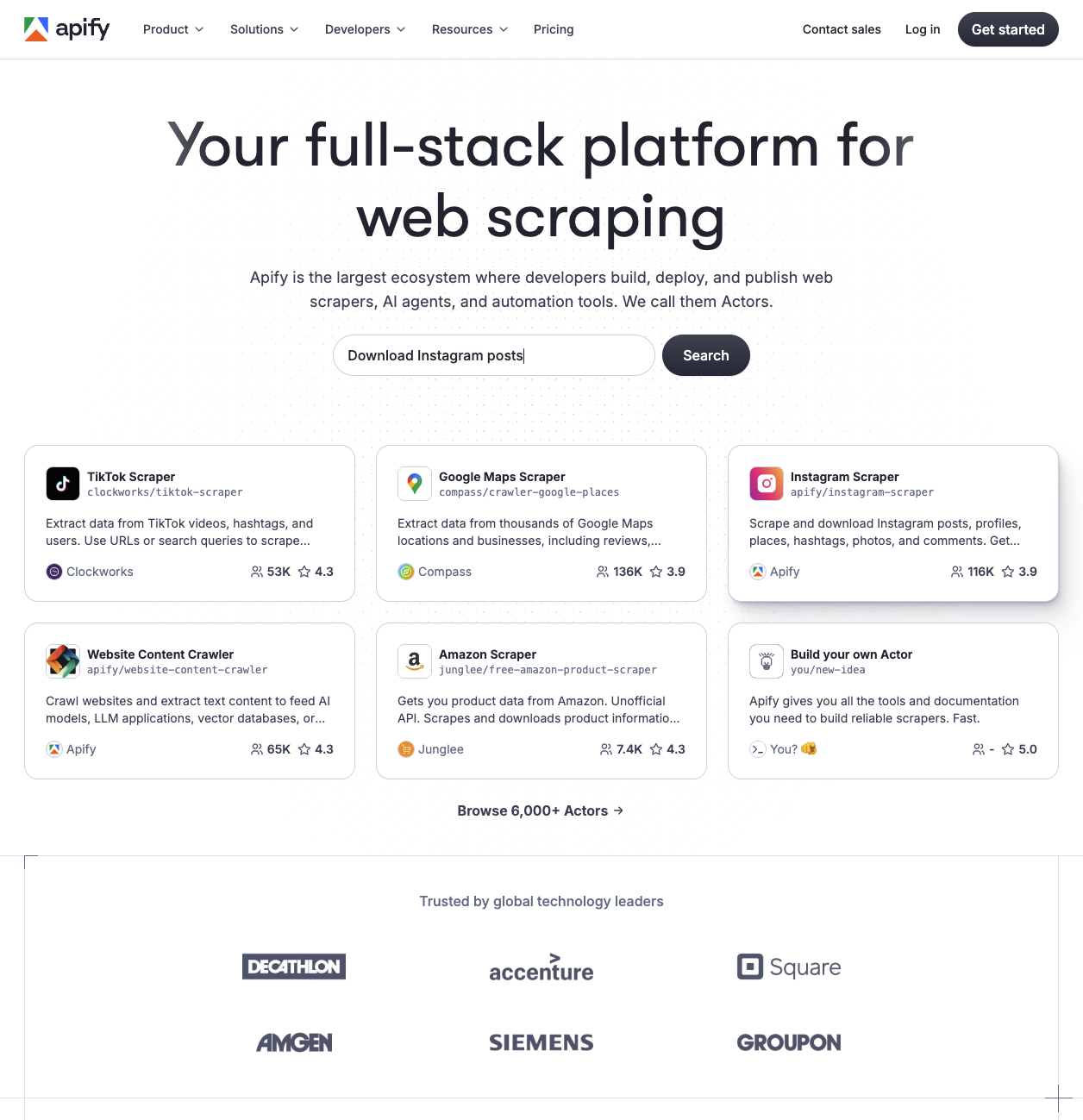

5. Apify

Трансформирует парсинг веб-страниц с помощью комплексного платформенного подхода

Apify произвел революцию в веб-парсинге, создав комплексную облачную платформу, объединяющую инструменты автоматизации, рынок и инфраструктуру в одном решении. Являясь программным обеспечением для очистки веб-страниц #1 на Capterra (2024 г.), пражская компания обслуживает более 55 002 активных пользователей в месяц благодаря своей инновационной архитектуре на основе Actor.

Ценообразование на основе платформы отличается от традиционных услуг: оплата на основе использования начинается с 39 долларов в месяц за 39 долларов в месяц за 39 долларов в виде кредитов на платформе. Первоначально стоимость вычислительных модулей (КУ) составляла 0,40 долл. США, а в бизнес-планах она снизилась до 0,25 долл. США. Уровень бесплатного пользования предусматривает ежемесячные кредиты на оценку в размере 5 долларов США. Стоимость прокси-сервисов составляет 7—8 долларов за ГБ для резидентных IP-адресов и 0,60—1,00 долларов за IP-адрес для прокси-серверов для центров обработки данных.

Торговая площадка Actor отличает Apify более чем 6000 готовых инструментов автоматизации, доступных для немедленного использования. Разработчики получают 80% дохода от публикаций Actors, создавая процветающую экосистему готовых скреперов для популярных платформ. Модели ценообразования включают бесплатные публичные актеры, ежемесячную аренду (обычно от 5—50 долларов) и варианты оплаты за результат.

В технической инфраструктуре особое внимание уделяется бессерверной масштабируемости за счет контейнеризации на основе Docker и автоматического выделения ресурсов. Платформа поддерживает пакеты SDK для JavaScript и Python с полной автоматизацией браузеров с помощью Puppeteer, Playwright и Selenium. Хранилище данных включает структурированные наборы данных, хранилища ключевых значений и очереди запросов с опциями экспорта JSON/CSV/Excel.

Инструменты для разработчиков отличаются исчерпывающей документацией, курсами Apify Academy и активной поддержкой сообщества. Платформа обрабатывает более 40 миллионов запусков Actor в месяц и 6,8 миллиарда вызовов API в год, обеспечивая при этом 99,95% времени безотказной работы. API-интерфейсы RESTful поддерживают 250 000 запросов в минуту благодаря уведомлениям с помощью веб-перехватчиков и интеграции сторонних разработчиков.

Отзывы клиентов подчеркивают простоту использования, экономичность и ценность готовых решений. Пользователи сообщают о снижении затрат в 10-20 раз по сравнению с альтернативами, такими как Clearbit, хотя и отмечают сложности для тех, кто не является разработчиком. Платформа эффективно обслуживает несколько сегментов пользователей: разработчики ценят гибкость, малые предприятия ценят готовые решения, а предприятия — функции надежности и соответствия требованиям.

6. API скрепера

Преуспевает в удобном для разработчиков сканировании веб-страниц

API скрепера зарекомендовал себя как лучший выбор для разработчиков, стремящихся к надежности без сложностей. Ежемесячно обрабатывая более 5 миллиардов запросов от более чем 10 000 компаний, сервис упрощает очистку веб-страниц, автоматически обрабатывая прокси, браузеры и капчи через единую конечную точку API.

Модель ценообразования компании, основанная на кредитах, начинается с 49 долларов в месяц за 100 000 кредитов API, что делает его значительно более доступным по сравнению с корпоративными альтернативами стоимостью от 500 долларов США. Базовые запросы занимают всего 1 кредит, а сложные операции, такие как рендеринг JavaScript с использованием премиум-прокси, достигают 25 кредитов. Этот метод оплаты по мере успеха взимает плату только за коды состояния 2xx, что позволяет избежать потерь, связанных с неудачными запросами.

Технические возможности сосредоточены на пуле прокси, насчитывающем более 40 миллионов прокси-серверов, охватывающих более 50 стран. Три уровня премиальных уровней обеспечивают разные показатели успеха и скорости. Общий показатель успеха сервиса составляет 62,9%, что выше среднего показателя по отрасли (59,3%), при этом он достигает 98% успеха на сайтах электронной коммерции и 93% в поисковых системах. Возможности рендеринга JavaScript позволяют обрабатывать динамический контент в браузерах Chrome без поддержки пользователей, что крайне важно для современных одностраничных приложений.

Опыт разработчиков получает высокую оценку благодаря комплексным пакетам SDK для Python, Node.js, PHP, Ruby и Java. Документация содержит подробные примеры кода, а пользователи сообщают, что время настройки составляет менее пяти минут. Однако время отклика составляет в среднем 11,4 секунды, что немного ниже отраслевого стандарта (9,4 с) которые могут повлиять на критически важные для производительности приложения.

Отзывы клиентов постоянно подчеркивают простоту использования и надежную поддержку клиентов, хотя некоторые пользователи отмечают сложность кредитной системы и географические ограничения низкоуровневых планов. Для стартапов и предприятий среднего размера, нуждающихся в предсказуемых затратах и простой интеграции, ScraperAPI предлагает отличную цену.

7. Осьминог

Обеспечьте визуальный парсинг, не требуя простоты написания кода

Octoparse доминирует на рынке визуального парсинга веб-страниц благодаря самому удобному интерфейсу и мощным возможностям автоматического обнаружения на основе искусственного интеллекта. Благодаря использованию подхода к извлечению данных без программирования он обслуживает более 1 миллиона пользователей по всему миру. Платформа предлагает более 469 готовых шаблонов для популярных веб-сайтов и комплексную облачную инфраструктуру.

Многоуровневое ценообразование предоставляет всем пользователям совершенно бесплатный план для небольших проектов (10 задач, только локальное исполнение), стандартный план за 119 долларов в месяц (100 задач, 6 параллельных облачных процессов) и план Professional за 299 долларов в месяц (250 задач, 20 параллельных процессов). Корпоративные планы предусматривают индивидуальное ценообразование, включающее более 750 задач, более 40 параллельных процессов и специализированное управление успехом.

Автоматическое распознавание ИИ платформы автоматически определяет шаблоны данных без ручной настройки, а визуальный конструктор рабочих процессов обеспечивает создание интерфейса с функцией перетаскивания. Octoparse обрабатывает динамические веб-сайты, включая JavaScript, AJAX и функцию бесконечной прокрутки с помощью встроенной функции ротации IP-адресов, распознавания CAPTCHA и управления прокси-серверами. Круглосуточное извлечение данных в облако с планированием обеспечивает непрерывный сбор данных.

Пользовательский интерфейс получил отличные оценки: 4,7/5 звезд на Capterra из 105 отзывов и 4,8/5 на G2. Пользователи постоянно хвалят простоту использования и мощные функции. Платформа предназначена для нетехнических пользователей, бизнес-аналитиков, компаний, занимающихся электронной коммерцией, и исследовательских организаций, предлагая подробные видеоуроки и круглосуточную поддержку клиентов по платным тарифным планам.

В отличие от решений на основе кода, требующих технических знаний, Octoparse обеспечивает полный комплексный парсинг без знаний в области программирования. Обширная библиотека шаблонов охватывает наиболее распространенные сценарии очистки, а функции на базе искусственного интеллекта автоматически обрабатывают изменения структуры веб-сайта. Облачная инфраструктура обеспечивает высокую продолжительность безотказной работы и масштабируемость проектов по извлечению данных корпоративного уровня, что делает ее идеальной для компаний, которым нужны решения для очистки данных «под ключ».

8. Соскабливание собаки

Превосходство в области экономичных специализированных API

Соскабливание собаки зарекомендовал себя как самое экономичное решение для очистки веб-страниц на рынке, обеспечивающее самую низкую цену за 1000 звонков (0,063 доллара США в масштабе) при сохранении 100% успеха на основных платформах. Основанная в 2018 году, компания ежемесячно обрабатывает более 400 миллионов запросов, уделяя особое внимание специализированным API для конкретных платформ.

Лидерство в ценообразовании способствует внедрению тарифных планов, стоимость которых начинается с 40 долларов в месяц, что обеспечивает исключительное соотношение цены и качества по сравнению с конкурентами. Система, основанная на кредитах, предоставляет 1000 бесплатных кредитов на тестирование, при этом стоимость каждого запроса начинается с 0,0002 долларов США и снижается до 0,000063 долларов США при больших объемах. Для разных API требуется разное количество кредитов: Google Search стоит 5 кредитов за запрос, в то время как для обычного просмотра веб-страниц требуется всего 1 кредит.

Специализированный подход к API отличает Scrapingdog от обычных сервисов парсинга, предлагая специализированные конечные точки для Amazon, Google, LinkedIn, Instagram, Indeed и других крупных платформ. Эти специализированные API возвращают проанализированные данные JSON, а не необработанный HTML-код, что устраняет необходимость в последующей обработке. Обычный веб-парсер работает с любыми веб-сайтами с премиальной ротацией прокси-серверов и возможностями рендеринга JavaScript.

Показатели производительности неизменно впечатляют: среднее время отклика составляет 2,5 секунды (значительно выше среднего показателя по отрасли (9,4 секунды) и 100% -ный показатель успеха на протестированных платформах, включая Amazon, Glassdoor и Idealista. Поддержка высокого уровня параллелизма в тарифных планах премиум-класса позволяет выполнять параллельную обработку без снижения производительности.

Опыт разработчиков подчеркивает простоту благодаря понятной документации, круглосуточной поддержке клиентов и примерам интеграции на нескольких языках программирования. Пользователи могут тестировать API прямо с панели управления без написания кода, а система обмена сообщениями обеспечивает немедленную техническую помощь. Для разработчиков, которым нужен надежный и доступный парсинг с поддержкой специализированной платформы, Scrapingdog предлагает исключительную ценность.

9. Муха

Сочетает опыт разработчиков с превосходными показателями успеха

Scrapfly позиционирует себя как ориентированную на разработчиков альтернативу корпоративным решениям, добившись успеха в 99,1%, что значительно выше среднего показателя по отрасли (59,3%) при сохранении доступных цен и отличной документации. Основанная для решения проблемы сложности услуг по очистке веб-страниц, платформа ежемесячно обрабатывает более 5 миллиардов запросов от более 30 000 пользователей.

Цены на основе кредитов начинаются с 30 долларов в месяц за 200 000 кредитов API, при этом потребление варьируется в зависимости от используемых функций. Базовый парсинг тратит 1 кредит на каждый запрос, а расширенные функции, такие как рендеринг JavaScript и использование резидентных прокси (более 130 миллионов IP-адресов из более чем 120 стран), пропорционально увеличивают затраты. Система обеспечивает предсказуемое выставление счетов по сравнению с альтернативами, основанными на полосе пропускания.

В технических возможностях основное внимание уделяется обходу защиты от ботов с помощью собственной системы ASP (Anti-Scraping Protection), которая динамически обновляет запросы для преодоления блокировок. При рендеринге JavaScript используются облачные браузеры с поддержкой настраиваемого исполнения, а функция преобразования форматов выводит исходный код HTML, JSON, Markdown или Clean HTML. Управление сеансами обеспечивает согласованность последовательностей запросов.

Опыт разработчиков платформы неизменно получает высокие оценки за дизайн API, качество документации и простоту интеграции. Пользователи сообщают о том, что время установки осталось менее нескольких часов, а подробные примеры кода приведены в репозиториях GitHub, содержащих более 40 целевых парсеров. SDK поддерживают Python с асинхронными возможностями, TypeScript/JavaScript для Node.js и интеграцию фреймворков, включая промежуточное ПО LangChain, LLamaIndex и Scrapy.

Последние инновации включают извлечение данных на основе искусственного интеллекта с использованием подсказок LLM и автоматическое извлечение продуктов, обзоров и статей. Унифицированный платформенный подход снижает сложность по сравнению с управлением отдельными прокси-серверами, браузерами и службами извлечения данных. Отзывы клиентов подчеркивают надежность и экономичность, хотя пользователи отмечают потенциальные непредвиденные расходы при автоматическом запуске функций ASP.

10. Ползание фейерверков

Превращает очистку с помощью экстракции на основе искусственного интеллекта

Firecrawl революционизирует очистку веб-страниц за счет извлечения данных на основе искусственного интеллекта, позволяющего анализировать контент семантически, а не структурно. Эта платформа на базе Y Combinator устраняет уязвимость традиционных селекторов CSS и делает ее предпочтительным выбором для разработчиков, создающих приложения искусственного интеллекта и современные конвейеры данных.

Цены, доступные для стартапов, начинаются с уровня бесплатного пользования, предлагающего 500 кредитов, за которым следуют планы Hobby по цене 16 долларов в месяц за 3000 кредитов. Стандартный уровень стоит 83 доллара в месяц за 100 000 кредитов, а уровень Growth достигает 333 долларов в месяц за 500 000 кредитов. Корпоративные клиенты получают неограниченное количество кредитов с индивидуальными лимитами ставок и соглашениями об уровне обслуживания. Эта простая кредитная система взимает плату за один кредит за очищенную страницу.

Агент FIRE-1 на платформе использует собственный искусственный интеллект для семантического понимания контента, что позволяет пользователям описывать потребности в извлечении информации простым английским языком, а не писать слабые селекторы. Firecrawl преобразует веб-сайты в чистые данные с разметкой, JSON и структурированные данные, специально оптимизированные для приложений LLM. Сервис обеспечивает расширенное выполнение JavaScript, поддержку SPA и интеллектуальное ожидание через несколько конечных точек API.

Опыт разработчиков получил высокую оценку благодаря исчерпывающей документации, пакетам SDK для Python и Node.js, а также встроенным интеграциям для LangChain, LlamaIndex и Zapier. Согласно результатам тестов, производительность платформы в 50 раз выше, чем у конкурентов, и при этом при использовании извлеченных данных экономия токенов на 2/3 по сравнению с GPT-4. Благодаря открытому исходному коду под управлением AGPL-3.0 разработчики могут самостоятельно размещать хостинг для обеспечения максимального контроля.

Отзывы клиентов постоянно подчеркивают повышение надежности и скорости по сравнению с традиционными подходами к очистке. В отличие от решений на основе прокси-серверов, требующих постоянного обслуживания, подход Firecrawl, ориентированный на искусственный интеллект, автоматически адаптируется к изменениям макета и прозрачно обрабатывает меры по борьбе с ботами. Разработчикам, создающим чат-ботов, системы RAG и базы знаний, Firecrawl предлагает превосходное качество данных и скорость разработки.

Выбор подходящего решения для очистки веб-страниц в соответствии с вашими потребностями

Для управляемых корпоративных потребностей, специальные решения Forage AI для искусственного интеллекта и комплексная визуальная платформа Sequentum обеспечивают пуленепробиваемую надежность. Стартапы с ограниченным бюджетом воспользуйтесь ценами Scrapingdog в размере 0,063/1 тыс. запросов и специализированными платформенными API. Приложения, ориентированные на ИИ следует учитывать возможности извлечения естественного языка MrScraper или возможности Firecrawl для понимания семантики.

Требования, основанные на проекте подходят управляемым услугам Grepsr по цене от 350 долларов США с выделенным управлением проектами. Потребности в визуальном соскобе - укажите на платформу Octoparse без кода с более чем 469 шаблонами и автоматическим определением искусственного интеллекта, в то время как разработчики, предпочитающие готовые решения сочтет, что более 6000 актеров Apify бесценны.

Растущие стартапы следует изучить планы ScraperAPI для разработчиков на 49 долларов в месяц, в то время как команды, нуждающиеся в максимальной гибкости воспользуйтесь превосходными показателями успеха Scrapfly в 95,9% и комплексными функциями API.

Заключение

Ландшафт веб-парсинга предлагает разнообразные решения для любого бюджета и технических требований: от извлечения естественного языка с помощью искусственного интеллекта до комплексных корпоративных платформ. Успех зависит от соответствия возможностей поставщика конкретным сценариям использования: бюджетным ограничениям, техническим требованиям, потребностям интеграции искусственного интеллекта и возможностям команды разработчиков.

Scrapingdog обеспечивает исключительную ценность для экономичных операций, в то время как MrScraper обеспечивает простоту использования технологий искусственного интеллекта для нетехнических пользователей. Sequentum трансформирует корпоративные операции путем комплексной визуальной разработки и Искусственный интеллект Forage предоставляет услуги «белых перчаток» для сложных управляемых требований.

Быстрый переход к извлечению данных на основе искусственного интеллекта и растущий спрос на структурированные данные делают выбор подходящего партнера решающим фактором долгосрочного успеха. Попробуйте начать с бесплатных пробных версий от нескольких поставщиков, чтобы оценить эффективность достижения конкретных целей, прежде чем переходить на годовые планы. Инвестиции в качественную инфраструктуру для очистки веб-страниц обычно окупаются за счет сокращения времени разработки, повышения качества данных и улучшения бизнес-аналитики, позволяющей принимать более эффективные решения.

Я являюсь соучредителем и генеральным директором Massive. Помимо работы над стартапами, я музыкант, спортсмен, ментор, ведущий мероприятий и волонтер.

Отзывы клиентов

Часто задаваемый вопрос

Какой самый дешевый сервис по очистке веб-страниц для стартапов?

+

Scrapingdog предлагает самую дорогую стоимость: 0,063 трелара за 1000 запросов в любом раскладе, а трагические планы начисляются с 40 треларов в мещацах. MrScraper также предлагает многогранные варианты экстракции на базе искусственного интеллекта по цене от 49 треларов в мец, а Firecrawl предполагает беплатный уровень с 500 кредитами на определение.

Какой инструмент для очистки веб-страниц лучше всего подходит для новичков?

+

MrScraper идеально подходит для новичков благодаря интерфейсу на естественном языке на основе искусственного интеллекта — просто укажите URL-адрес и опишите, какие данные вам нужны. Octoparse также отлично подходит для нетехнических пользователей благодаря визуальному интерфейсу «укажи и щелкни» и более 469 готовых шаблонов для популярных веб-сайтов.

Нужны ли мне навыки программирования для использования сервисов веб-парсинга?

+

Для нескольких платформ программирование не требуется. MrScraper использует искусственный интеллект и команды на естественном языке, Octoparse предоставляет визуальный интерфейс перетаскивания, а Sequentum предлагает очистку методом «укажи и щелкни». Однако такие сервисы, как ScraperAPI и Scrapingdog, требуют базовых знаний в области интеграции API.

В чем разница между API для очистки веб-страниц и управляемыми сервисами?

+

API для очистки веб-страниц (например, ScraperAPI, Scrapingdog) требуют, чтобы вы самостоятельно интегрировали процесс очистки и управляли им, обеспечивая больший контроль и снижая затраты. Управляемые сервисы (такие как Grepsr, Forage AI) решат все за вас, включая настройку, обслуживание и доставку данных, но по более высокой цене, начиная с 350-500 долларов в месяц.

Какой сервис для очистки веб-страниц лучше всего обрабатывает капчи и обнаружение ботов?

+

Sequentum лидирует в области защиты от ботов благодаря усовершенствованной технологии рандомизации отпечатков пальцев и технологии «трансформера». MrScraper и ScraperAPI также отлично обходят капчи в автоматическом режиме, а Scrapfly обеспечивает 95,9% успеха благодаря своей запатентованной системе защиты от царапин (ASP).

Могут ли службы очистки веб-страниц извлекать данные с веб-сайтов с интенсивным использованием JavaScript?

+

Да, большинство современных сервисов обрабатывают рендеринг JavaScript. Firecrawl специализируется на одностраничных приложениях, ScraperAPI предлагает браузеры Chrome без проблем, Sequentum обеспечивает полную автоматизацию браузера, а Apify поддерживает Puppeteer, Playwright и Selenium для сложных сайтов на JavaScript.

Законно ли использование сервисов веб-парсинга?

+

Тка веб-страниц, как правило, законна при сборе зародышевых данных и особенностях условий обучения веб-сайта. Подобные сервисты, такие как ForageAI и Grepsr, подсказывают соблюдение GDPR и CCPA. Всегда проверяйте файлы robots.txt и слова облегчения целевого веб-сайта перед очицей их.

Какой сервис лучше всего подходит для очистки крупных предприятий?

+

Sequentum Enterprise лидирует в сфере крупномасштабных операций с комплексными функциями по цене от 5000 долларов США в год. Forage AI предоставляет управляемые услуги «белых перчаток» для решения сложных корпоративных задач, а Grepsr предлагает масштабируемое управляемое извлечение данных по цене от 350 долларов для предприятий среднего размера.

Как выбрать разные модели ценообразования?

+

Ценообразование на основе кредитов (ScraperAPI, MrScraper, Firecrawl) хорошо подходит для предсказуемых моделей использования. Цены с оплатой за каждую запись (Grepsr) гарантируют, что вы платите только за полезные данные. Управляемые услуги (Forage AI) устраняют технические издержки, но стоят дороже. Учитывайте свои технические знания, объем данных и бюджетные ограничения.

Какой лучший сервис для очистки веб-страниц для проектов искусственного интеллекта и машинного обучения?

+

Firecrawl отлично подходит для проектов искусственного интеллекта с оптимизированным для LLM выводом и семантическим пониманием. Forage AI обеспечивает извлечение данных на основе искусственного интеллекта и понимание контекстных данных. MrScraper предлагает извлечение естественного языка на основе искусственного интеллекта, а на рынке Apify есть множество инструментов автоматизации, ориентированных на искусственный интеллект.