eBay — одна из крупнейших торговых площадок электронной коммерции в мире, на которой представлены миллиарды объявлений на сайте ebay и которая ежедневно привлекает миллионы посетителей. Для компаний данные о продуктах eBay представляют собой множество ценных данных, которые могут оказаться бесценными для бизнес-аналитики, маркетинговых исследований и анализа конкурентов. Однако процесс крупномасштабного извлечения данных из eBay в Интернете сопряжен с серьезными техническими проблемами из-за усовершенствованных механизмов защиты платформы от скрейпинга.

В этом пошаговом руководстве объясняется, как создать веб-парсер eBay с использованием прокси-сети Massive для эффективного извлечения данных о объявлениях eBay и минимизации риска блокировки.

Без лишних слов, давайте начнем!

Зачем собирать данные eBay?

Необработанные данные с веб-сайта ebay дают компаниям бесценную информацию, которая способствует принятию обоснованных решений и конкурентному преимуществу. Вот как общедоступные данные eBay меняют бизнес-стратегии:

- Исследование рынка: Отслеживая цены конкурентов, рекламные акции и предпочтения клиентов в режиме реального времени, вы можете выявить пробелы на рынке и скорректировать свою стратегию, чтобы превзойти конкурентов.

- Умное ценообразование: Отслеживание колебаний цен на eBay позволяет корректировать цены, чтобы оставаться конкурентоспособными при сохранении высокой рентабельности. Это особенно полезно на быстро меняющихся рынках, где цены часто меняются или во время сезонных пиков.

- Решения по продуктам: Используйте данные о продажах и отзывах eBay, чтобы подтвердить выбор продуктов, прежде чем вкладывать средства в новый инвентарь. Анализируя то, что хорошо продается, и учитывая отзывы клиентов, вы сможете усовершенствовать ассортимент своих продуктов и рассчитать сроки их выпуска для достижения максимального эффекта.

- Управление запасами: Данные eBay показывают четкую структуру спроса, что позволяет поддерживать оптимальный уровень запасов. Это помогает оптимизировать уровень запасов, избежать их завышения и предотвратить их нехватку.

Избегайте блокировки при очистке eBay

Собрать скребок eBay не так просто, как кажется. Масштабная очистка eBay сопряжена с серьезными трудностями из-за ограничений скорости на основе IP-адресов, введения CAPTCHA и строгих мер по борьбе со скрейпингом. Если вы превысите лимит запросов на eBay, ваш IP-адрес будет заблокирован или на него будут введены капчи.

Зачем нужны прокси для парсинга на eBay?

При создании парсера eBay для масштабной обработки данных eBay прокси-серверы не только полезны, но и необходимы. Использование прокси-серверов позволяет распределять запросы по нескольким IP-адресам, что поможет вам:

- Избегайте блокировки или дросселирования

- Поддерживайте постоянную скорость очистки

- Предотвращение занесения IP-адресов в черный список (решение этой проблемы может оказаться огромной проблемой)

- Надежное масштабирование сбора данных

Зачем выбирать массивные прокси для очистки eBay?

Как мы уже обсуждали выше, очистить данные с eBay непросто. Вы должны рассмотреть возможность использования некоторых прокси и резидентные прокси являются наиболее предпочтительными. Наши использование резидентных прокси IP-адреса с реальных настольных и мобильных устройств, что делает их очень эффективными в обход мер eBay по борьбе со скрейпингом. Вот что мы предлагаем:

- Высокий уровень успеха: Наши резидентные IP-адреса значительно снижают риски блокировки, обеспечивая надежный крупномасштабный сбор данных.

- Глобальный доступ: Легко собирайте данные с любой торговой площадки eBay по всему миру, используя прокси-серверы для конкретных регионов.

- Точные локальные данные: Ориентируйтесь на конкретные города или страны, чтобы получить точную информацию о рынке и данные о ценах.

- Гарантированная производительность: Обеспечьте 99% успеха благодаря быстрому реагированию и круглосуточному мониторингу работоспособности.

- Гибкое использование: Выберите один из различных вариантов полосы пропускания в соответствии с вашими потребностями в очистке, будь то малый или корпоративный уровень.

💡 Совет профессионала: Всегда используйте прокси из вашей целевой страны при просмотре различных торговых площадок eBay — это гарантирует получение актуальных местных данных о ценах и наличии свободных мест. Massive Proxies предоставляет IP-адреса с указанием местоположения на всех основных рынках eBay для получения стабильных результатов.

Начало работы с массивными прокси

Если вы новичок в Massive, зарегистрируйте аккаунт. Выберите план, соответствующий вашим потребностям.

Примечание: Мы предлагаем Бесплатная пробная версия 2 ГБ для компаний. Для начала заполните эту форму. Если вам нужна большая пропускная способность, свяжитесь с нашим отделом продаж, и мы вам поможем.

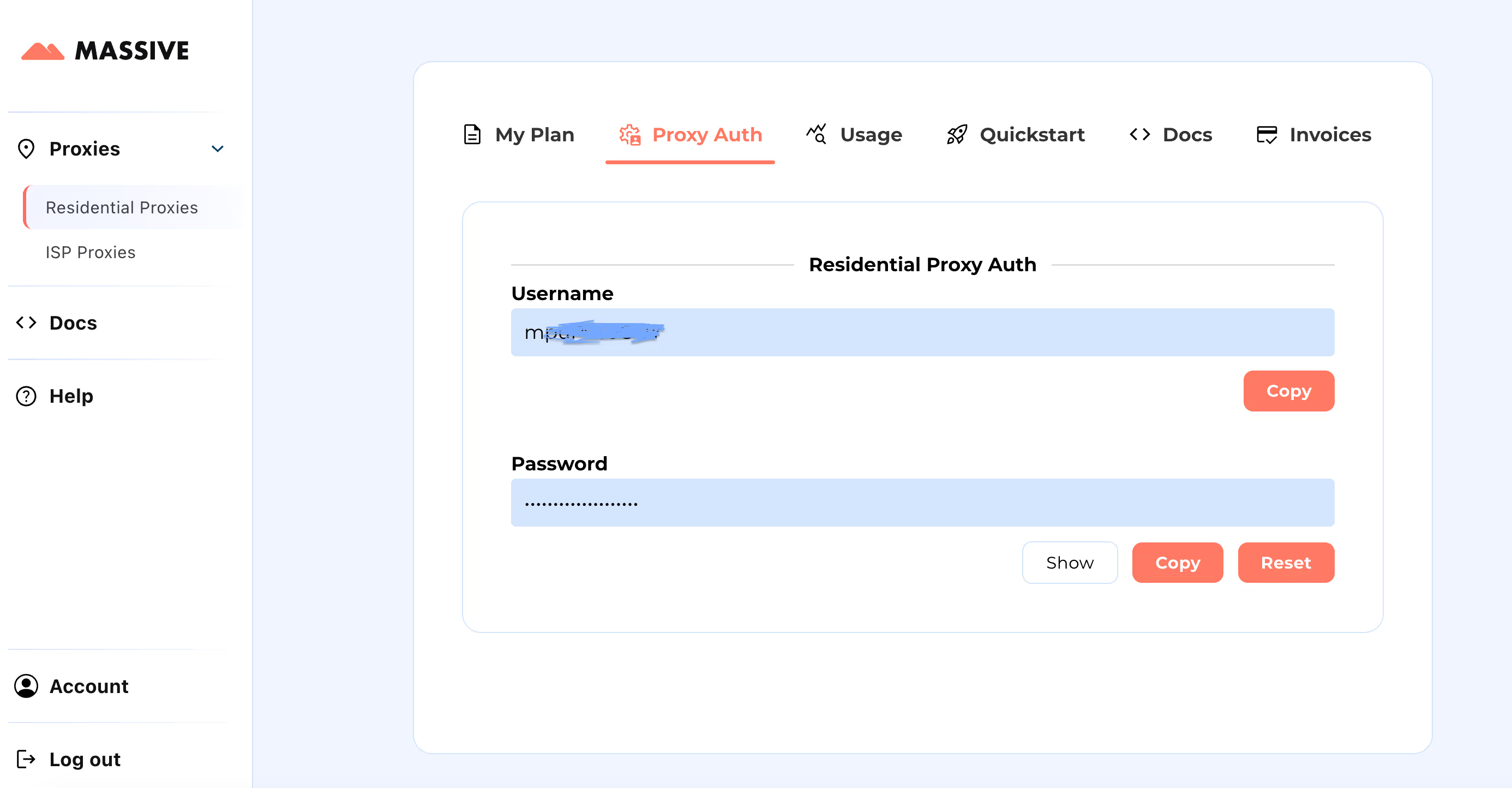

После регистрации перейдите на Массивная панель управления для получения учетных данных прокси-сервера (имя пользователя и пароль).

Этапы настройки:

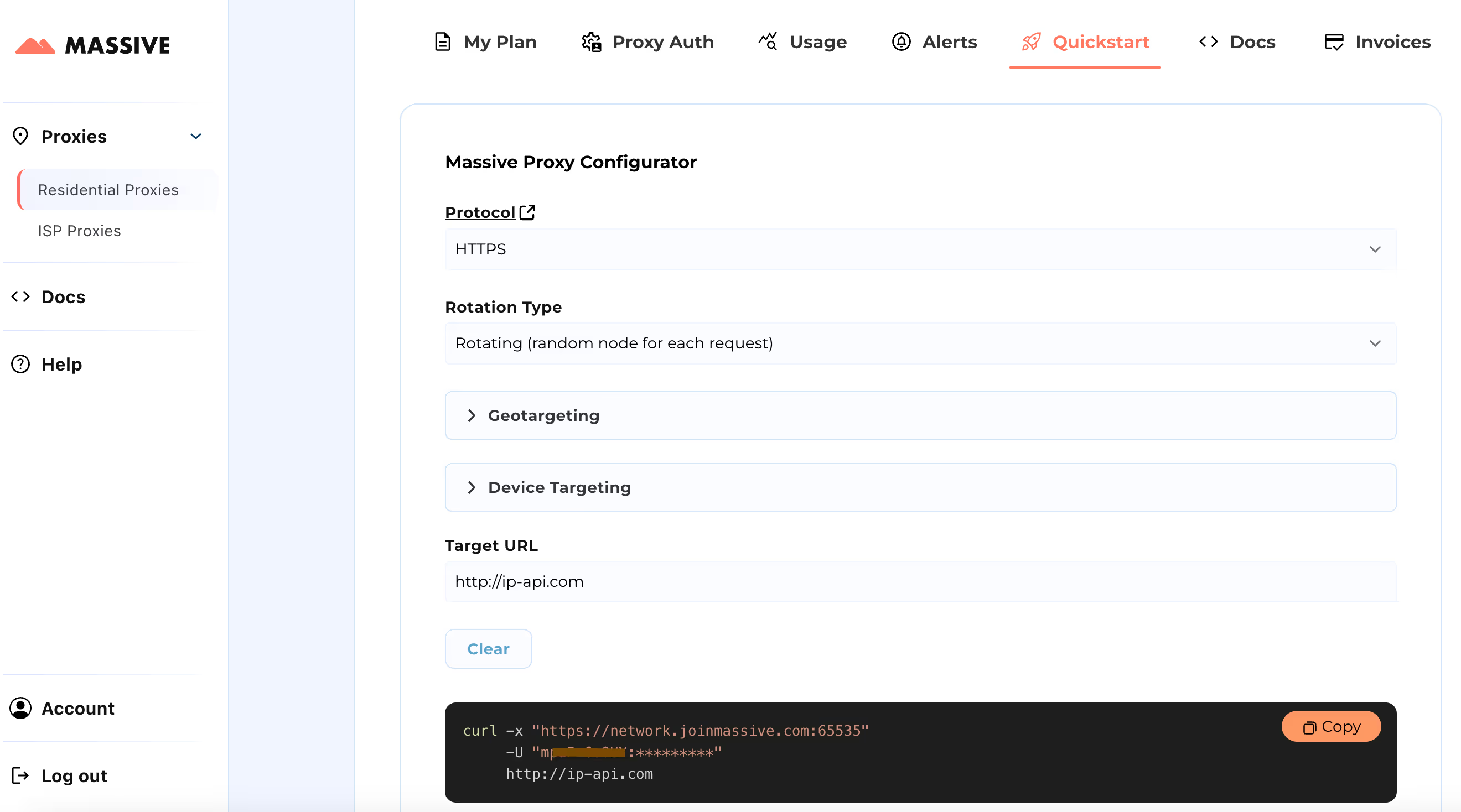

Посетите Быстрый старт раздел для настройки параметров прокси-сервера:

- Выберите предпочтительный протокол (HTTP, HTTPS или SOCKS5)

- Выберите между вращающиеся или липкие прокси

- Задайте настройки геотаргетинга (страна, штат, город или почтовый индекс)

После настройки вы получите готовую к использованию команду cURL для вашего конкретного варианта использования.

Дополнительные функции, такие как таргетинг на основе местоположения и фиксированные сеансы, см. в Обширная документация. В документации представлены пошаговые инструкции по максимально эффективному использованию прокси-серверов Massive Residential.

Благодаря этой настройке вы можете использовать Massive Proxies для сбора данных eBay с основных торговых площадок, включая США, Великобританию, Германию и Австралию.

Какие данные о товарах можно извлечь из eBay?

Очистка eBay может предоставить вам множество информации о продукте. Вот исчерпывающая разбивка доступных данных:

- URL-адрес продукта: Ссылка на страницу продукта eBay

- Заголовок: Название предмета

- Подзаголовок: Дополнительный описательный текст

- Текущая цена: Текущая цена продажи

- Цена Was: Предыдущая цена (при наличии)

- Скидка: Процент или сумма скидки

- Доступность: Доступное количество и состояние запасов

- Количество проданных: Количество проданных товаров

- Сведения о доставке: Стоимость и ориентировочное время доставки

- Местонахождение: Происхождение доставки

- Возвращает: Детали политики возврата

- Состояние: Является ли товар новым, подержанным или отремонтированным

- Бренд: Название производителя или торговой марки

- Тип: Катогория или тип продукта

- Репозиция о свёте:

- Название свца/мазина

- Процент отзывов

- Общий объём свёз свца

Обязательные путевые входы

Чтобы начать очистку eBay, вам необходимо указать два ключевых параметра:

- Целевая страна: Вы можете изложить данные из 10 региональных документов eBay:

"US": "https://www.ebay.com",

"GB": "https://www.ebay.co.uk",

"DE": "https://www.ebay.de",

"ES": "https://www.ebay.es",

"FR": "https://www.ebay.fr",

"IT": "https://www.ebay.it",

"CA": "https://www.ebay.ca",

"MX": "https://www.mx.ebay.com",

"NL": "https://www.ebay.nl",

"AU": "https://www.ebay.com.au"- Поисковые термины: Верите то, что вы хотите поражать (например, «кресло с откидной спиной», «камеры дрона»). Вы можете ввести несколько слов, заветные.

- Лимит товаров: (Предназначено) Укажите, сколько элементов не нужно очищать. Пропустите эту опцию, чтобы забрать все достойные данные на всех страницах.

Извещенные данные будут сохранены в структурированном файле JSON.

Создание пара данных eBay с помощью масивных прокси

В этом руководстве шаг за шагом рассказывается, как пользоваться eBay. Полка мы сочетанным на очке eBay.com (сайт в США), те же причины применяются к сайтам eBay в других странах с небольшими войсками в селекторах.

Шаг #1: Настройка проекта

Во‑первых, убедитесь, что в вашей системе установлен Python 3. Если нет, скажите и установите его.

Теперь создайте каталог для своего проекта:

mkdir ebay_scraperОткройте папку проекта в вспомогательной среде IDE (пример, код VS) и создайте файл с именем США_ebay.py. Этот файл будет содержать нашу логику очистки данных eBay.

Вам также необходимо создать файл.env для хранения ютных данных Massive Proxy:

PROXY_USERNAME=your_username

PROXY_PASSWORD=your_passwordТеперь структура вашего проекта должна выделять следующим разумом:

ebay_scraper/

├── .env

└── usa_ebay.py

Шаг #2: уставка зависимостей

Чтобы обычно обращаться к данным eBay, вам необходимо использовать несколько ключевых библиков:

- curl_cffi: Высокопроизводительный HTTP-код, задающий дактилоскопию JA3/TLS и HTTP/2

- тушный суд 4: Для цинаксического анализа HTML

- python-dotenv: для управления переменными окружениями

- аэрофалы: Для асинхёрных продуктов с файлами

Теперь вы можете установить эти заделы с помощью пункта, как ни ниже:

pip install curl-cffi beautifulsoup4 python-dotenv aiofiles

Шаг #3. Настройка масивных прокси

На этом трепе нарастает прокси-сервер, обеспечивающий гетаргетинг и обеспечивающий кратефикацию залов через определенные сроки для точного изложения данных eBay:

def setup_proxy(self):

"""Configure proxy settings for geotargeted requests"""

self.proxy_host = "network.joinmassive.com:65534"

self.username = os.getenv("PROXY_USERNAME")

self.password = os.getenv("PROXY_PASSWORD")

self.proxy_auth = f"{self.username}-country-{self.domain}:{self.password}"

Шаг #4: запросите контрафию

Настройте HTTP-запросы с помощью curl_cffi бибиотека. Настройка включает два метода:

_get_proxy_config: Матирует обучающие данные для аутентификации и представления о хоре_удачный_запрос: Обрабатывает выполнение HTTP-запросов с помощью таких функций, как подтверждение скорости и эмуляция браузера

def _get_proxy_config(self) -> Dict[str, str]:

"""Generate proxy configuration dictionary"""

return {"https": f"http://{self.proxy_auth}@{self.proxy_host}"}

async def _make_request(self, session: AsyncSession, url: str, page_type: str):

"""Make HTTP request with proxy and browser emulation"""

async with self.semaphore:

response = await session.get(

url,

proxies=self._get_proxy_config(),

impersonate="chrome124",

timeout=self.page_timeout,

)

Шаг #5: притка страниц поисков

Этот метод Страница_процесса_поиска_процесса Управляет каждой отдельной страницей детей поиска. В качестве входных данных используются асинхронный сеянс, нотариц и поковый проц. Вот как работает это:

Они создают URL-адрес поисковой системы, создавая параметры запроса, которые включают вас в:

- Ключевое слово для поиска (

_сейчас) - Номер страницы ()

_pgn) - Настройка количества элементов на странице (

_ipg2) лизировано до 240 наименовых

Тем не менее, он отдает асинхронный запрос, а также ранее подобранный метод запроса. Если содержит полученное ушно, оно азируется с помощью Петушный суд с lxml парцер. Затем он указывает URL-адрес файлов из проанализированного HTML-кода и вводит URL-адреса файлов в пакетном режиме.

async def _process_search_page(

self, session: AsyncSession, page_num: int, search_term: str

):

"""Process a single search results page"""

try:

params = {

"_nkw": search_term,

"_pgn": page_num,

"_ipg": 240, # Maximum items per page

}

url = self.base_url + urlencode(params)

status_code, html_content = await self._make_request(session, url, "search")

if html_content:

soup = BeautifulSoup(html_content, "lxml")

urls = self._extract_product_urls(soup)

logger.info(f"Found {len(urls)} products on page {page_num}")

return await self._process_product_batch(session, urls)

except Exception as e:

logger.error(f"Error processing page {page_num}: {str(e)}")

return False, False

Шаг #6: определение URL-адресов продуктов

Этот метод решает важнейшую задачу определения URL-адресов адресов адресов со страниц и источников поиска. Вот как работает определение URL-адресов адресов продуктов:

The _извлечение_URL-адреса_продуктов_ методид применяет метод BeautifulSoup, содержит анализирующий HTML-контент и возвращает список действенных URL-адресов файлов файлов. Он отражает направленный подход к указателю URL-адресов:

- Использует селектор CSS

a.s-item__linkчтобы найти все элементы сок на плоты - Выполняет итарку по каждому элеганту ссылки для определения атрибута href

- Проверит URL-адреса, верия и другие

артикул/в пути URL-адреса - Создает отфильтрованный список, содержащий толированный действенный URL-адрес продуктов

def _extract_product_urls(self, soup: BeautifulSoup) -> List[str]:

"""Extract product URLs from search results page"""

urls = []

for link in soup.select("a.s-item__link"):

url = link.get("href", "")

if url and "itm/" in url:

urls.append(url)

return urls

Шаг #7: очистка сведений о продуктах

Метод _extract_product_details систематики изучен о продукте со страниц продуктов eBay. Он обхватывает прекрасный суп и вбирает в себя информацию о продукте, содержащую ачий стручковатые данные.

def _extract_product_details(self, soup: BeautifulSoup, url: str) -> ProductDetails:

"""Extract all product details from page"""

details = ProductDetails(url=url)

try:

details.store_info = DataExtractor.extract_store_info(soup)

# Title section

if title_div := soup.select_one("div.x-item-title"):

if title := title_div.select_one("h1.x-item-title__mainTitle span"):

details.title = title.text.strip()

if subtitle := title_div.select_one("div.x-item-title__subTitle span"):

details.subtitle = subtitle.text.strip()

# Price section

if price_section := soup.select_one("div.x-price-section"):

if current_price := price_section.select_one("div.x-price-primary span"):

details.current_price = current_price.text.strip()

if was_price := price_section.select_one(

"span.ux-textspans--STRIKETHROUGH"

):

details.was_price = was_price.text.strip()

# Discount calculation

discount = None

if emphasis_discount := price_section.select_one(

"span.ux-textspans--EMPHASIS"

):

discount = emphasis_discount.text.strip()

elif secondary_discount := price_section.select_one(

"span.ux-textspans--SECONDARY"

):

discount = secondary_discount.text.strip()

if discount and (percentage_match := re.search(r"(\d+)%", discount)):

details.discount = percentage_match.group(1) + "%"

# Quantity section

if quantity_div := soup.select_one("div.x-quantity__availability"):

spans = quantity_div.select("span.ux-textspans")

if spans:

details.availability = spans[0].text.strip()

if len(spans) > 1:

details.sold_count = spans[1].text.strip()

# Shipping section

if shipping_div := soup.select_one("div.d-shipping-minview"):

if shipping_section := shipping_div.select_one(

"div.ux-labels-values__values-content"

):

details.shipping, details.location = (

DataExtractor.extract_shipping_info(shipping_section)

)

# Returns section

if returns_div := soup.select_one("div.x-returns-minview"):

if returns_section := returns_div.select_one(

"div.ux-labels-values__values-content"

):

details.returns = DataExtractor.extract_returns_info(returns_section)

# Additional details

if condition_span := soup.select_one(

"div.x-item-condition-max-view .ux-section__item > span.ux-textspans"

):

details.condition = condition_span.text.strip().split(".")[0] + "."

if (brand_dl := soup.select_one("dl.ux-labels-values--brand")) and (

brand_value := brand_dl.select_one("dd .ux-textspans")

):

details.brand = brand_value.text.strip()

if (type_dl := soup.select_one("dl.ux-labels-values--type")) and (

type_value := type_dl.select_one("dd .ux-textspans")

):

details.type = type_value.text.strip()

except Exception as e:

logger.error(f"Error extracting details from {url}: {str(e)}")

return details

Шаг #8: Тя разбивания на страницы

The _имеетется_жеюля_страница метод предлагает два раза подхода для проверки разбиения на страницы:

- Начала он ищется слку на следующую страницу, а якорный тег с помощью

type="следующий»атрибут. Если эта ссылка существует и действительнаhrefатрибут, он подтверждает наличие следующей страницы. - В качестве резервного механизма он также проверяет наличие следующего элемента кнопки. Это ищет кнопку с

type="следующий»и проверяет, не отключен ли он, отметивинвалид арииатрибут. Если кнопка существует, но не отключена, это означает, что доступно больше страниц.

def _has_next_page(self, soup: BeautifulSoup) -> bool:

"""Determine if there is a next page of results"""

next_link = soup.select_one('a[type="next"]')

if next_link and next_link.get("href"):

return True

next_button = soup.select_one('button[type="next"]')

return not (next_button and next_button.get("aria-disabled") == "true")

Шаг #9: Хранение данных

Наконец, сохраните извлеченные данные в файл JSON:

class FileHandler:

"""Handle file operations with error handling and backups"""

@staticmethod

async def save_to_file(filename: str, data: Dict):

"""Save data with automatic backup creation"""

temp_file = f"{filename}.temp"

backup_file = f"{filename}.backup"

try:

# Create directory structure

os.makedirs(os.path.dirname(filename), exist_ok=True)

# Save to temporary file

async with aiofiles.open(temp_file, "w", encoding="utf-8") as f:

await f.write(json.dumps(data, indent=2, ensure_ascii=False))

# Create backup of existing file

if os.path.exists(filename):

os.replace(filename, backup_file)

# Replace with new file

os.replace(temp_file, filename)

logger.info(f"Data successfully saved to {filename}")

except Exception as e:

logger.error(f"Error saving data: {str(e)}")

raise

Шаг #10: Запустите скребок

Полная реализация для анализа eBay в 10 доменах торговой площадки доступна на GitHub. Скрепер извлекает данные о продукте и создает структурированный файл JSON, каждая запись которого содержит:

{

"url": "https://www.ebay.com/itm/294701001393",

"title": "Manual Recliner Armchair PU Sofa Chair w/ Adjustable Leg Rest & 135° Reclining",

"subtitle": "Comfortable & Easy to Clean & 360° Swivel & Steel Frame",

"current_price": "US $228.99",

"was_price": "US $651.99",

"discount": "65%",

"availability": "More than 10 available",

"sold_count": "93 sold",

"shipping": "Free shipping - Arrives by Christmas",

"location": "Wilsonville, Oregon, United States",

"returns": "30 days returns Buyer pays for return shipping",

"condition": "A brand-new, unused, unopened, undamaged item in its original packaging (where packaging is applicable).",

"brand": "Homcom",

"type": "Recliner Armchair",

"store_info": {

"name": "Aosom-Direct",

"feedback": "97.5% positive feedback",

"sales": "482K items sold",

},

}

Заключение

В этом руководстве показано, как создать скребок eBay, который будет работать на разных торговых площадках eBay. Используя резидентные прокси, вы можете собирать точные данные о продуктах, сводя к минимуму риски блокировки. Рассмотренный нами подход позволяет надежно собирать данные с различных региональных сайтов eBay.

Если вам нужна дополнительная информация о настройке прокси-сервера или передовых практиках, вы найдете все в документация.

Готовы начать? Подпишитесь на Massive Proxies сегодня 🚀

Я являюсь соучредителем и генеральным директором Massive. Помимо работы над стартапами, я музыкант, спортсмен, ментор, ведущий мероприятий и волонтер.